先の「特許データで自然言語処理」からは少し離れて、ベーシックな特許分析をJupyter Notebookでどう行っていくかについて解説していきます。自然言語処理と異なり、形態素解析のことは考えないので、Windows環境でもとりあえず、anaconda.comからAnacondaをダウンロードしてデフォルト設定でインストールしてしまえば処理を試してみることができます。インストールが終わったら、Jupyter Notebookのショートカットから起動するだけです。

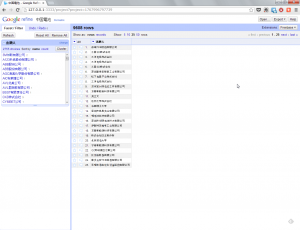

サンプルとして先の記事でも使ったZITの特許データリストを用いた処理を行っていきます。Excel形式でpatentdata.xlsxという名前で予めJupyter Notebookの作業フォルダに保存してあります。

まずは、pandasとNumpyをインポートします

import pandas as pd

import numpy as np

df1 = pd.read_excel('patentdata.xlsx')

df1.head()

df1['出願日'].dt.year.head()

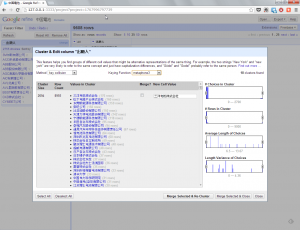

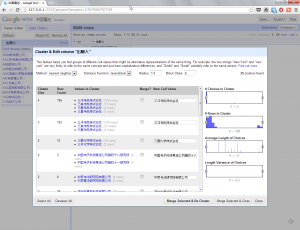

df1['公報番号'].groupby(df1['出願日'].dt.year).count()

df1['公報番号'].groupby([df1['出願人'], df1['出願日'].dt.year]).count()